Ludzie nie ogarnęli prezentacji ChatGPT 4o. Szef OpenAI zareagował

Prezentacja ChatGPT z nowym modelem GPT-4o wywołała spore zamieszanie. Szef OpenAI postanowił rozwiać powstałe wątpliwości.

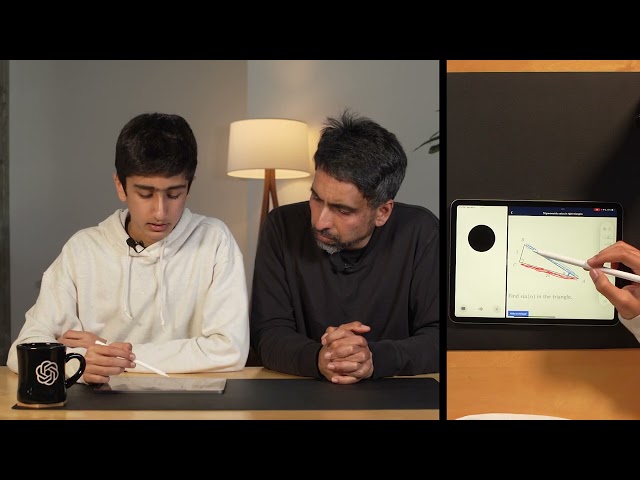

13 maja światło dzienne ujrzała nowa wersja dużego modelu językowego o nazwie GPT-4o, która zdążyła już trafić do użytkowników ChatGPT, w tym darmowej wersji. Show skradła jednak prezentacja nowego trybu głosowego, który ma umożliwić prowadzenie z AI wyjątkowo naturalnych konwersacji.

Od tygodnia użytkownicy z całego świata katują tryb głosowy ChatGPT. Na samym TikToku widziałem już kilkanaście filmów, których autorzy krytykują niezgodność z możliwościami zaprezentowanymi przez OpenAI lub - co chyba jeszcze zabawniejsze - rozpływają się w zachwytach. Jest tylko jeden problem.

Nowy tryb głosowy ChatGPT 4o nie jest jeszcze dostępny

Na razie użytkownicy mogą korzystać jedynie z tekstowych możliwości modelu GPT-4o. Mimo że OpenAI wyraźnie podkreśliło podczas prezentacji i w komunikacje prasowym, że nowy Voice Mode zostanie dodany "w ciągu kilku tygodni", z jakiegoś powodu przekaz ten do wielu osób nie dotarł.

Co zatem tak ochoczo testują i zachwalają/krytykują użytkownicy oraz dziennikarze technologiczni? Zwykły tryb głosowy, który trafił do aplikacji ChatGPT we wrześniu 2023 roku.

Do całego zamieszania odniósł się szef OpenAI. "Dla jasności - nowy tryb głosowy nie został jeszcze dostarczony (chociaż tryb tekstowy GPT-4o został). To, czego obecnie używacie w aplikacji, to stara wersja" - napisał na X (dawny Twitter) Sam Altman.

ChatGPT 4o - czym się różny nowy tryb głosowy od starego?

Pierwsza wersja trybu głosowego jest - jak na dzisiejsze standardy - dość prymitywna, bo opiera się na trzech różnych sieciach neuronowych. Aplikacja ChatGPT najpierw zamienia mowę na tekst, później wysyła tekstowe zapytanie do modelu GPT, a uzyskaną odpowiedź zamienia na mowę.

Tak działająca funkcja ma sporo wad. Po pierwsze - działanie aż trzech różnych systemów jest wolne, przez co oczekiwanie na odpowiedź trwa kilka sekund, co zabija dynamikę konwersacji. Po drugie - do GPT trafia jedynie transkrypcja zapytania, więc aplikacja w ogóle nie odróżnia głosów, tonu wypowiedzi czy dźwięków w tle.

Wolna od tych ograniczeń jest właśnie nowa wersja trybu głosowego ChatGPT. Wykorzystuje ona pojedynczą sieć neuronową, która jest budowana od podstaw z myślą o komunikacji werbalnej w czasie rzeczywistym. Jak widać na filmach promocyjnych, sztuczna inteligencja reaguje na różne głosy, dźwięki czy tony wypowiedzi i można jej przerwać w połowie zdania. Dzięki tym usprawnieniom komunikacja z AI ma przypominać rozmowę z człowiekiem.

W przyszłości ChatGPT ma dostać także usprawnione rozpoznawanie obrazu, dzięki czemu możliwe będzie prowadzenie konwersacji na temat obrazu przechwytywanego przez kamerę smartfonu.

Nowy tryb głosowy ma zostać udostępniony publicznie w ciągu kilku tygodni wyłącznie użytkownikom płatnej usługi ChatGPT Plus. Twórcy podkreślają swoją świadomość, że rozbudowane możliwości GPT-4o "stwarzają szereg nowych zagrożeń", dlatego w fazie alpha funkcjonalność usługi ma być w jakiś sposób ograniczona.

Komentarze

8ale różny od czego?

A ja mam IPhone i wiecie dzięki mnie można bulo wyświetlać nawigację z iPhone na ekranie tego komputerka i wszystko działAlo pięknie!!

To pokazuje jak iPhone i IOS bije na głowę wszysztkie telefony z andrutem!!! Dzięki mnie i iPhone dojechaliśmy do celu!