Bez dwóch zdań NVIDIA wprowadzając DLSS poczyniła istotny krok z punktu widzenia graczy ochoczo korzystających z rozdzielczości wyższych niż 1080p oraz zainteresowanych Ray Tracingiem.

Oczywiście AMD wraz z Intelem nie byli dłużni, dlatego w odpowiedzi na poczynania Zielonych sprezentowali własne techniki upscalingu obrazu w grach pod postacią FSR oraz XeSS. Jednocześnie pracują nad nowymi dodatkowymi usprawnieniami, które mają na celu poprawę płynności i jakości obrazu. Tym samym musimy przyjąć do wiadomości, że te rozwiązania zostaną już z nami na dobre. Teoretycznie jeśli chcemy zakończyć epokę dominacji paneli Full HD taki kierunek wydaje się jedynym słusznym. Szczególnie jeśli mamy dokonać płynnego przejścia w szerszą niż do tej pory adaptację Ray Tracingu.

W telegraficznym skrócie, co to jest upscaling?

Upscaling to popularne rozwiązanie polegające na przekonwertowaniu materiału źródłowego o niższej rozdzielczości do finalnego obrazu w wyższej rozdzielczości. W grach PC pozwala przede wszystkim uzyskać więcej klatek na sekundę. GPU, renderując grafikę w niższej rozdzielczości, jest mniej zapracowane, bez problemu wypluwając więcej fps-ów. Pamiętajmy jednak, że w praktyce konieczne jest znalezienie złotego środka. Przykładowo, im niższa rozdzielczość wejściowa, tym więcej fps-ów, ale odbije się to negatywnie na finalnej jakości obrazu.

Świetnym przykładem podstawowego upscalingu jest wprowadzony w 2019 NVIDIA Image Scaling (w skrócie NIS) oraz późniejszy Radeon Super Resolution (AMD RSR). Obie działają z poziomu sterownika. Nie wymagają implementacji bezpośrednio w silniku gry, choć bywają od tego odstępstwa. NVIDIA udostępniła wszystkie konieczne narzędzia dla twórców gier, aby ci mogli łatwo uwzględnić opcję on/off NIS w swoim tytule, acz niestety mało kto to robi. Pewnie większość doszła do wniosku, że woli poświęcić siły przerobowe na drugie dziecko Zielonych pod postacią DLSS.

NIS czy RSR – która metoda lepsza?

W bezpośrednim porównaniu lepiej wypada NVIDIA Image Scaling niż AMD Radeon Super Resolution. W przypadku NIS w trybie 85 proc. obraz końcowy jest naprawdę zaskakująco dobry. Wszystko poniżej oznacza już kompromis poświęcenia szczegółowości obrazu na rzecz dodatkowych klatek na sekundę. Dla optymalnego działania zalecam wybierać NIS albo RSR w przypadku monitorów 2560 x 1440 px lub większych. Na monitorach 1920 x 1080 px rezultaty bywają raczej mieszane.

NVIDIA Image Scaling to nie tylko upscaling, ale także wyostrzanie obrazu. Z poziomu sterownika mamy pełną dowolność regulacji zakresie 0 do 100. Domyślnie zobaczymy 50 proc. Jak na mój gust ta wartość i każda kolejna wyżej sprawia, że obraz wygląda nienaturalnie. W punkt będzie przedział około 35 proc. W sumie po prostu trzeba samemu popróbować i przekonać się, co nam pasuje.

DLSS, czyli AI w służbie gamingu

W 2018 roku NVIDIA wprowadziła układy Turing. Karty RTX 20 od wcześniejszych GTX odróżnia obecnością rdzeni RT, które służą do obliczeń związanych ze śledzeniem promieni. Ten względem PC narzuca wręcz drakońskie wymagania. Dlatego opracowano DLSS. Deep Learning Super Sampling to bardziej zaawansowana metoda upscalingu niż wspomniany wcześniej NIS. Po prawdzie jednak tylko upraszczam, ponieważ upscaling to tylko jedna z technik zaprzęgnięta do DLSS. W jego skład wchodzi jeszcze uczenie maszynowe oraz wygładzanie krawędzi. Jest jeszcze pewien detal, mianowicie NIS i DLSS kompatybilne są wyłącznie z kartami NVIDII. Ten pierwszy działa z każdym układem GeForce GTX oraz RTX. Natomiast DLSS wymaga dedykowanych rdzeni Tensor obecnych tylko w kartach GeForce RTX.

Pierwsza wersja DLSS z 2018 roku pozostawiała wiele do życzenia w kwestii jakości obrazu. Nie bez przyczyny skrót rozbijano na „Doesn't Look So Sharp”. Słowem - miejscami rezultaty wyglądały tak źle, że lepiej było pominąć DLSS. Szczególnie, jeśli próbowaliśmy nowego wynalazku na rozdzielczościach niższych niż 4K. Prędko jednak wprowadzono wersję 2.0 wraz z kartami RTX 20 Super. Zasadniczo naprawiła ona większość istotnych problemów i oczywiście jest ona rozwijana do dziś. DLSS 2.0 działa z każdą kartą RTX. Boost w wyświetlanych klatkach zależy od wersji rdzeni Tensor, a więc generacyjnych usprawnień architektury.

NVIDIA wprowadza nowe rozwiązani i komplikuje nazewnictwo

Karty graficzne RTX 40 dodały nowość w postaci Optical Flow Accelerator. Wchodzi ona w skład DLSS 3.0, który dzieli się na trzy współgrające moduły: DLSS 2.0, NV Reflex oraz Frame Generation. Ostatni moduł to generator klatek, gdzie algorytmy uczenia maszynowego analizuje postępujące po sobie obrazy pozwalając tak interpolować klatki animacji. Otrzymujemy dodatkową klatkę obrazu między dwiema wygenerowanymi przez GPU, wpływając pozytywnie na wrażenie płynności animacji. Pamiętajmy tylko, że przykładowo nasze oczy widzą 60 klatek, ale pod palcami na klawiaturze gra wciąż działa w powiedzmy 30 klatkach. Generator odbywa się też kosztem opóźnienia sygnału (latency), plus wymaga dodatkowych zasobów pamięci VRAM. DLSS 3.0 został zarezerwowany wyłącznie dla serii RTX 40, acz społeczność moderów pokazała, że da się obejść ograniczenia NVIDII, adaptując Frame Generation dla wcześniejsczych RTX-ów. Do osiągnięcia tego skorzystano z kodu FSR 3.0.

NVIDIA nie była by sobą, gdyby nie dorzuciła do pieca, komplikując bardziej nazewnictwo. Jako ostatni został wprowadzony DLSS 3.5, skupiony na podniesieniu walorów wizualnych ray tracingu. W tym celu wprowadzono technikę ray reconstruction (rekonstrukcja promieni), która za pośrednictwem sieci neuronowej odszumia obraz generowany przy pomocy śledzenia promieni. W trakcie tego procesu nie oczekujcie znaczącego wzrostu wydajności, chodzi wyłącznie o aspekt wizualny. DLSS 3.5 może być uruchmiony na każdej karcie RTX, łącznie z pierwszymi modelami z 2018 roku. Jakiś czas temu została udostępniona wersja DLSS 3.7.0, czyli zestaw aktualizacji dających znacznie wyraźniejszą grafikę, zwiększoną stabilność szczegółów, redukuję ghostingu i poprawię stabilności temporalnej w zestawieniu z DLSS 3.5. Można ją pobrać ręcznie, następnie podmieniając w katalogu gry plik nvngx_dlss.dll.

AMD kontratakuje, czyli FidelityFX Super Resolution w praktyce

AMD świetnie radzi sobie w segmencie procesorów, ale w przypadku kart graficznych od lat wyłącznie goni za NVIDIĄ, reagując z dużym opóźnieniem na poczynania konkurenta. Cała ta rewolucja śledzenia promieni i DLSS nasypała gruzu w trybiki działu kart graficznych AMD, który i tak już dostawał sporej zadyszki. Z opóźnieniem odpowiedzią na DLSS miał być FidelityFX Super Resolution, czyli w skrócie FSR. Technikę tę wprowadzono wraz z układami Radeon RX 6000. Problem w tym, że seria 6000 w przeciwieństwie do kart RTX NVIDII nie posiada analogicznych rdzeni Tensor. Tym samym FSR nie bazuje na uczeniu maszynowym i podobnie jak NIS czy AMD RSR jest techniką skalowania przestrzennego.

W tym miejscu spytacie, jaka jest różnica między RSR a FSR? Ten pierwszy ręcznie uruchamiamy z poziomu sterownika, dlatego w teorii działa z każdą grą. Jednak chcąc z niego skorzystać, musimy posiadać Radeona serii 5000, 6000 albo 7000. Trzeba tylko pamiętać, aby gra była zawsze uruchamiana z trybie pełnoekranowym. Natomiast FSR uruchamiamy w grze i działa z prawie każdą kartą graficzną, o ile ta wspiera standard Shader 5.0. FidelityFX Super Resolution wykazuje kompatybilność z nowościami od AMD oraz skamielinami pokroju RX 470 czy R9 280X, które dziś mają ponad dekadę na karku. Na tym nie koniec, bo FSR uruchomimy także z kartami GeForce GTX 700, GTX 900, 1000 czy nawet młodszymi RTX-ami. Na koniec FSR implementujemy w silnik gry a tym samym w przeciwieństwie do RSR działa precyzyjniej.

Naśladując NVIDIĘ, pod oznaczeniem FSR 1.0 oraz 2.0 ukrywa się narzędzie do upscalowania obrazu. Natomiast wprowadzony w 2023 roku FSR 3.0 to technika generowania klatek, podobna do DLSS 3.0, acz ponownie do działania nie wymaga obecności dedykowanych rdzeni bazujących na AI. Dlatego propozycję AMD w kwestii upłynniania animacji możemy uruchomić praktycznie z dowolną kartą graficzną. Pierwotnie generator klatek działa nierozerwalnie z upscalerem. Niedawno Czerwoni wprowadzili ważną aktualizację FSR 3.1, uwzględniającą istotne poprawki do upscalingu i generatora klatek. Według AMD ulepszono jakość obrazu, skupiając się na lepszej stabilności, zmniejszonym migotaniu i redukcji powidoków. Długo oczekiwaną funkcją aktualizacji FSR 3.1 jest też oddzielenie generatora od upscalingu. Zasadniczo pozwala to na użycie XeSS lub DLSS w połączeniu z generatorem klatek FSR, co daje nowe możliwości i potencjalnie ciekawe rezultaty.

Desant Intela na rynek dedykowanych GPU i prezentacja XeSS

Technologie dynamicznego upscallingu wykorzystujące AI stały się niezwykle popularne. Na rynku PC zdecydowanym liderem jest DLSS wprowadzony przez NVIDIĘ. FSR nie korzysta z AI, choć jeśli pamięć mnie nie myli AMD bardzo dawno temu obiecało, że wzorem kart RTX wprowadzą dedykowaną akcelerację AI. Niby coś się dzieje w tym temacie, ale konkretów wciąż brak.

Tymczasem Intel wszedł odważnie do segmentu dedykowanych kart graficznych, przy okazji oferując to, co najlepsze z obu światów NVIDII i AMD. Teoretycznie Niebiescy mogli zaadaptować rozwiązanie AMD, które jest w pełni otwarte, ale decyzja padła na opracowanie własnego standardu. Ma to sens, ponieważ dzięki temu Intel wpływa na rozwój autorskiego rozwiązania i poprzez optymalizację wykorzysta możliwości oferowanego sprzętu. Tym sposobem wprowadzono Xe Super Sampling, znany jako XeSS.

Intel Xe Super Sampling w połączeniu z architekturą kart Intel Arc wykorzystuje algorytmy głębokiego uczenia maszynowego. Pozwala na to obecność jednostek XMX (Xe Matrix Extensions). GPU renderuje obraz w niższej rozdzielczości, a następnie zostaje on przetworzony przez sieć neuronową analizującą m.in. wektory ruchu odpowiadające za klarowność obrazu w dynamicznych scenach. Finalnie obraz zostaje podniesiony do wyższej rozdzielczości z wykorzystaniem szeregu technik pomocniczych. Słowem XeSS blisko do NVIDIA DLSS z numerkiem 2 niż FSR.

Jednak w przeciwieństwie do NVIDII Intel wzorem AMD poszedł ścieżką otwarcia swojego standardu – przynajmniej częściowo. Nie wchodząc w techniczne detale XeSS, bazujący na AI, można użytkować nie tylko na kartach Intel Arc 700, acz wtedy odbywa się to z pominięciem jednostek XMX. Z powodzeniem działa na układach Radeon i GeForce, czym przypomina FSR. Sporo zależy od samych twórców i to jak zaimplementują standard Intela. Przykładowo w Dying Light 2 Intel XeSS swobodnie działał z kartami GeForce RTX, ale już właściciele AMD Radeon RX musieli obejść się smakiem. Dla kontrastu w Cyberpunk 2077 takiego problemu nie było.

W chwili spisywania tego tekstu XeSS nie posiada jeszcze swojego generatora klatek, acz prace nad nim wciąż trwają. Rozwiązanie to ma pojawić się na rynku pod nazwą Intel ExtraSS Frame Generation. Po pierwsze będzie opierało się na supersamplingu i ekstrapolacji klatek, gdzie dla porównania NVIDIA i AMD w swoich analogicznych rozwiązaniach wykorzystują interpolację. Jednocześnie propozycja Niebieskich ma działać na kartach graficznych każdego producenta.

Oczekiwania a rzeczywistość: czy warto stosować upscaling a jeśli tak to, który?

W ankiecie zamieszczonej pod krótkim tekstem z lipca 2020 czytelnicy Benchmarka pokazali, że upscaling nie jest bliski ich sercu. Cztery lata później techniki upscalowania obrazu w grach to już nieodłączny element PeCetowego świata. Powoli wchodzą też do współczesnych konsol. Osobiście DLSS i to, co zapoczątkował uznaję za coś ważniejszego niż Ray Tracing i rewolucję graficzną, jaką rzekomo miał ze sobą przynieść. Niemniej argumentem graczy jest to, że współczesne metody upscalingu rozleniwiają twórców, którzy nie dopracowują swoich dzieł. Szczerze nieważne czy DLSS / FSR / XeSS są lub nie są dostępne – spartaczone pod względem optymalizacji gry były, są i będą wypuszczane na rynek.

No dobrze to, który upscaler jest godny polecenia? DLSS to na tyle dojrzałe rozwiązaniem, że spokojnie można go polecić każdemu użytkownikowi kart GeForce RTX. Obraz stoi na wysokim poziomie. Przykładowo 4K upscalowane w trybie jakości z rozdzielczości 1080p dziś potrafi zaskoczyć jakością. Bez dwóch zdań to duże osiągnięcie. Dzięki temu użytkownik może płynnie przejść na monitor o wyższych parametrach. Do tego karta renderując grafikę w niższej rozdzielczości jest mniej zapracowana, co przekłada się na mniejszy pobór energii oraz niższe temperatury i hałas. Trzeba jedynie pamiętać o odpowiednio mocnym CPU, który pozwoli skorzystać z potencjalnego boostu klatek, jeśli akurat to przemawia do Was najbardziej.

Na bazie FSR 3.1 można odnieść wrażenie, że AMD wykonuje zawsze dwa kroki do przodu i jeden do tyłu. Mianowicie poprawili sporo, ale do ideału wciąż daleka droga. Niemiej trzeba przyznać, że od wersji 1.0 wykonali naprawdę sporo dobrej roboty. Testując GTX 1080 Ti z monitorem 1440p pobawiłem się FSR 2.0 w Cyberpunk 2077, Robocop Rouge City, Horizon Forbiddent West oraz The Finals. Analizując obraz od strony czysto technicznej zawsze można się do czegoś przyczepić. Ale gdy tylko skupiłem się na rozgrywce w Cyberpunk dość prędko zapomniałem, że FSR jest włączony. Podobnie było z Robocopem. W Horizon traci do natywnego obrazu więcej, ale wciąż da się spokojnie grać. Najsłabiej wyglądał The Finals. Słowem jeśli nie możemy pozwolić sobie na zakup nowej karty graficznej to, czemu nie przedłużyć służby obecnie siedzącej w PC z pomocą FSR? Zwłaszcza, że nic to nie kosztuje. Porostu spróbujcie, całkiem możliwe że rezultat zaskoczy.

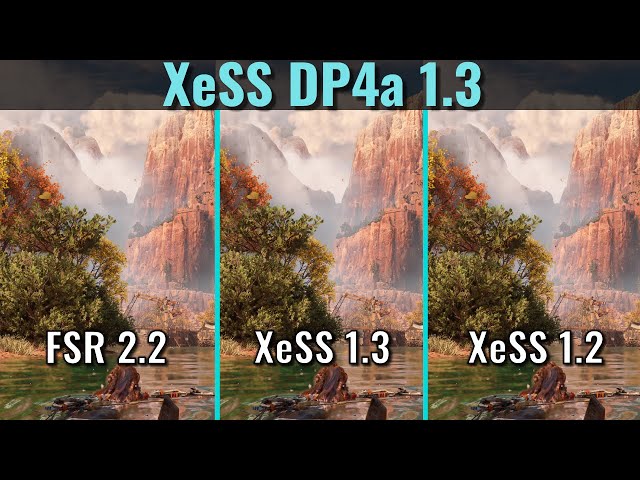

W całym tym wyścigu XeSS Intela wciąż goni konkurentów. Jeśli posiadacie układ z rodziny Arc powinniście wypróbować, co potrafi bo rezultaty zaskakują. W najnowszej wersji niewiele brakuje lub stoi wręcz na równi z DLSS. Natomiast sprawdzając XeSS z innymi kartami daje bardzo nierówne efekty. Przykładowo w The Finals z użyciem karty serii GTX 10 jakość obrazu drastycznie ustępowała FSR. Problemem Intelowej propozycji był też słaby lub wręcz znikomy boost klatek na kartach GeForce albo Radeon. Korzystając z wersji 1.1 albo 1.2 doświadczyłem tego bezpośrednio w choćby Cyberpunk 2077. Jeśli idzie o samą jakość obrazu rezultaty bywały mieszane. Ponownie w Cyberpunk XeSS jest ostrzejszy niż FSR, ale w innych grach nagminnie dokuczały mu artefakty, migotanie tekstur itd.

Co jednak ważne wprowadzona niedawno wersja XeSS 1.3 naprawiła większość niedogodności, oferując też boost fps-ów. Na próbę potrzebne narzędzie możecie pobrać ręcznie. Chcąc cieszyć się wersją 1.3 w grze wspierającej natywnie XeSS wystarczy podmienić w folderze gry plik libxess.dll. Najlepiej aby gra jednak dostała oficjalną łatkę twórców do wersji 1.3. Krótki test przeprowadziłem w Forbiddent West oraz Cyberpunk z użyciem GTX 1080 Ti, gdzie wyniki przeszły moje oczekiwania. Od razu widać spore usprawnienia w postaci kilku procentowym przyroście fps-ów i stabilności obrazu. W Horizon zniknęły też irytujące artefakty. Niestety testując z GTX 970 wersję 1.3 rezultat był katastrofalny w choćby w Forbiddent West. Gra wyciągała ledwo 10 fps a obraz wyglądał niczym papka. Zatem nie wszystkie leciwe GPU mogą liczyć na pozytywne rezultaty.

Zabawę z upscalingiem jednak rezerwowałbym głównie dla monitorów 1440p lub z większych. W 1080p rezultaty to istna loteria. Przykładowo w Cyberpunk użytkując DLSS z rozdzielczością 1920 x 1080 obiekty oddalone wyglądają ogółem tak sobie. Problem ten dodatkowo nasila się po uruchomieniu generatora klatek. A FSR w Wiedźminie 3 to dosłownie przysłowiowa mydelniczka. Pamiętajmy też, że ta sama technika w różnych tytułach często daje inny reultat. Mianowicie w jednej grze FSR, DLSS albo XeSS prezentują się dobrze, ale już w innej coś może nie grać. Dzieje się tak dlatego, ponieważ twórcy gier ręcznie implementują te rozwiązania z różnym skutkiem. Dopiero niedawno Microsoft udostępnił pierwszą próbną wersję DirectSR, czyli API mającego ujednolicić, uprościć, słowem zestandaryzować proces implementacji upscalerów.

Generatory Klatek: dobrodziejstwo czy przekleństwo?

Pierwsza wersja DLSS 3.0 bombardowała oczy artefaktami albo powidokami, gdzie o opóźnieniach systemu już nawet nie wspomnę. NVIDIA Reflex rekomendowany do pracy z DLSS 3.0 ten ostatni problem w miarę prostował. Dziś upłynniacz obrazu zaproponowany przez NVIDIĘ działa poprawnie. Minie trochę czasu nim AMD albo Intel w ogóle dogoni swojego konkurenta. Wydaje się jednak, że gracze początkowo oburzeni byli nie z powodu problemów wizualnych a obawy o fizyczne kastrowanie kart graficznych na rzecz funkcji wykorzystujących AI. Zresztą premiera RTX 4060 oraz 4060 Ti pozostawiły spory niesmak, niejako trochę potwierdzając tę teorię spiskową. Jednocześnie generator fps-ów nie mogę nazwać upscalerem. Piszę o nim ze względu na silną korelację z bazowym DLSS lub FSR.

Problem generatora klatek wynika z błędnego marketingu. Po pierwsze nie można traktować go w kategoriach boostu wydajności, jak miało to miejsce w przypadku DLSS 2.0 i analogicznych rozwiązań AMD oraz Intela. Jest to upłynniacz obrazu, dający wrażenie płynności i nic ponad to. Do osiągnięcia należytego rezultatu pierw komputer bez żadnej pomocy powinien sam osiągnąć stabilne 60 klatek i dopiero na to nanosimy nadbudowę generatora wspartego przez upscaler. W przypadku topowych układów graficznych jest to świetny sposób na przeskoczenie wąskiego gardła, kiedy CPU ogranicza GPU a chcielibyście np. dobić do wyższego odświeżania monitora. Rzecz wartościowa w grach dla pojedynczego gracza. Wtedy generator będzie przysłowiową wisienką na torcie. Jednak ze względu na swoją specyfikę pracy generator klatek nie nadadje się do gier sieciowych, szczególnie tam gdzie wymagana jest precyzja i szybkość reakcji.

Pamiętajmy też, że generator magicznie nie zwiększy wydajności budżetowego GPU albo ogółem leciwego PC, do poziomu porównywalnego ze współczesnymi maszynami. Nie będzie też sposobem na przekroczenie fizycznych ograniczeń układu graficznego, pozwalając na więcej niż GPU faktycznie jest w stanie udźwignąć. Dla przykładu testując RTX 4060 i 4060 Ti 8GB ze starszymi konfiguracjami rezultaty prezentowały sinusoidę. Ze wględu na charakterystykę tych kart, szczególnie na gruncie pamięci, można natknąć się na scenariusz skrajnie niesatysfakcjonujący. Dłubiąc głębiej, jeśli idzie o generator klatek trzeba brać jeszcze pod uwagę V-sync (obie rzeczy niespiecjalnie się lubią) a także ręczne blokowanie fps-ów przez użytkownika, np. do wartości odświeżania monitora. Problem jest na tyle złożony, że wymaga osobnej publikacji, dlatego teraz wyłącznie sygnalizuję pewne kwestie.

Słowem podsumowania

Temat nie został wyczerpany, bo o pewnych zagadanieniach udało mi się tylko wspomnieć. Wypadałoby choćby napisać też trochę o Lossless Scaling, ale ponownie aplikacja dostępna na Steam zasługuje na dedykowany materiał. Wracając do głównego wątku, generalnie Ray Tracing nigdy nie był dla mnie elementem, który mógłby zdecydować o wyborze karty graficznej. Natomiast technika upscalowania, szczególnie w przypadku chęci przesiadki na monitor 1440p, w sumie już tak. Dlatego rozumiem, że obecność DLSS może przeważyć o zakupie karty RTX. Tych samym odczuć nie mam jednak wględem generatora klatek. Ciekawy dodatek, ale raczej traktowałbym go w kategoriach bonusu a nie remedium na starzejący się sprzęt lub ogólnie przeciętną czy słabą wydajność GPU i CPU. Pamiętajmy też, że „sztuczne” klatki nie biorą się z powietrza i gospodarują one sporą część pamięci VRAM. Już teraz mamy gry spokojnie absorbujące 12GB VRAM, co dla graczy oznacza dodatkowe stresy.

Wdrażanie AI do świata gier nie zwalnia. NVIDIA pracuje nad wersją 4.0 swojego DLSS, gdzie ponoć zakres obowiązków uczenia maszynowego ma iść dalej. Co z tego się urodzi tylko czas pokaże. Wprowadzone przez Zielonych pomysły spowodowały mniejsze lub większe ożywienie na dość skostniałym rynku kart graficznych. Dzięki temu AMD wprowadził FSR, który niejednokrotnie dał drugie życie układom pochodzącym z zupełnie innej epoki: serie RX 400, 500, RX5000, GTX 900, GTX 1000 itd. Intel też nie próżnuje. Teraz zasadniczo wszystko w rękach twórców gier i tego jak będą implementować te rozwiązania. Efekty zaskakują. Przykład Ghost of Tsushima, gdzie z poziomy gry możecie jednocześnie uruchomić generator klatek FSR w połączeniu z upscalingiem DLSS. Oby takich pomysłów było więcej.

Komentarze

7Wystarczy nie kupować kart graficznych co generację a szczególnie topowych nowości i cierpliwie poczekać trochę aż skok technologiczny będzie wyraźny.