Każdy szanujący się dziś wyświetlacz, a w szczególności telewizor, posiada wsparcie dla HDR. Ale czym tak naprawdę jest ów standard oraz czy zawsze oznacza to samo? Z tego artykułu dowiecie się wszystkiego, co istotne w kwestii wysokiego zakresu dynamiki.

Jeżeli szukacie obecnie najlepszego telewizora albo monitora dla graczy, to z pewnością wiecie już, że „musi mieć HDR”. To taki rodzaj wiedzy powszechnej, której geneza często nie jest do końca dobrze rozumiana. Dodatkowo często nawet nie zdajemy sobie sprawy z tego, że HDR nie zawsze oznacza to samo (a w zasadzie nigdy tak nie jest) i że istnieje kilka standardów przetwarzania obrazu z HDR. Te oraz pozostałe wątpliwości postaramy się dla Was rozwiać w niniejszym artykule. Oto siedem rzeczy, które warto wiedzieć o HDR:

- Czym jest dynamika obrazu?

- Na co wpływa użycie HDR?

- Jakie istnieją standardy HDR oraz czym się różnią?

- Czym są techniki „automatycznego HDR”?

- Jaki sprzęt najlepiej radzi sobie z HDR?

- Skąd brać treści zapisane w HDR?

- HDR a gry – o czym warto wiedzieć?

Czym jest dynamika obrazu?

Skrót HDR wywodzi się z języka angielskiego, w którym to rozwija się go do „High Dynamic Range”, co z kolei można przetłumaczyć wprost na wysoki zakres dynamiki. Dynamiki czego zapytacie? Oczywiście obrazu, który jest wyświetlany. A co w tym przypadku oznacza sama dynamika? Otóż odnosi się do różnicy w jasności pomiędzy najciemniejszymi fragmentami sceny a tymi najjaśniejszymi. Zatem w zasadzie mówimy tu o technice, która znacząco podnosi kontrast odtwarzanych mediów, tak aby wyświetlany obraz bardziej przypominał to, co w rzeczywistości jest w stanie rejestrować nasze oko (ludzie naturalnie „widzą w HDR” ;)).

Dzięki HDR ujrzymy więcej detali w skrajnie ciemnych, jak i jasnych fragmentach sceny.

W tym miejscu koniecznie jeszcze musimy zaznaczyć, że HDR dotyczy nie tylko wyświetlaczy, ale również sprzętu do przechwytywania obrazu, a nawet odnosi się do dźwięku. To, o czym będziemy pisać w dalszej części artykułu, traktuje tylko i wyłącznie o HDR w kontekście odtwarzania obrazu, a w szczególności wideo.

Na co wpływa HDR?

Na ilustracji powyżej dobrze pokazany jest problem, z jakim mierzą się wyświetlacze SDR (Standard Dynamic Range) – gdy na scenie pojawia się bardzo jasny obiekt (jak słońce), to cała scena zostaje nienaturalnie rozjaśniona. Tymczasem bardziej naturalnie i bliżej tego, jak my sami postrzegamy tego typu sceny (na żywo), wygląda obraz, w którym rozpiętość zakresu jasności sceny jest znacznie większa i wyświetlacz może pokazać znacznie więcej różnych poziomów jasności.

HDR nawet w pełnej krasie nadal nie wygląda tak dobrze, jak rzeczywistość, ale jest jej znacznie bliższy niż SDR.

Zwyczajnie w przypadku SDR treści są ściskane, tak aby najjaśniejszy punkt dowolnej sceny nie przekraczał 100 nitów, podczas gdy treści HDR w zależności od standardu mogą sięgać nawet do 10 tysięcy nitów! Powyżej też widać, że poza kontrastem spada również nasycenie barw, co wynika bezpośrednio z tego, że jasność w zasadzie tworzy barwy i mając mniejszy jej zakres również nie uzyskamy tak soczystych kolorów, jakie występują w naturze.

Obraz z SDR zwyczajnie jest bardziej wyblakły - pod warunkiem, że nasz wyświetlacz faktycznie potrafi wykorzystać HDR.

Dla treści SDR stosuje się przestrzeń kolorów (gamut) zwaną sRGB lub inaczej Rec.709, podczas gdy treści w HDR zwykle są mapowane w znacznie szerszym gamucie DCI-P3, a coraz częściej zaczyna stosować się gamut BT.2020 (zwany również Rec.2020), któremu znacznie bliżej do możliwości percepcji ludzkiego oka (a miejscami nawet poza nie wykracza). Poniżej możecie zobaczyć wizualizację dla takiego pokrycia kolorów na telewizorze, który realizuje w 100% sRGB oraz niemal w pełni pokrywa BT.2020.

Przerywana linia to wzorcowe pokrycie gamutu (po lewej sRGB, po prawej BT.2020), ciągła szara linia to przestrzeń widoczna dla ludzkiego oka.

Ostatecznie jednak sama zdolność do reprodukcji to jedno, ale w przypadku HDR równie kluczowa jest tak zwana objętość gamutu, zatem to, na ile jasne powinny być dane barwy, ponieważ ponownie – to jasność i kontrast sprawiają, że obraz wydaje się dla nas żywy. W tej kwestii HDR dopiero pokazuje swoją moc, oferując rząd wielkości większe nasycenie.

Z góry wygląda podobnie, ale jeżeli dodamy parametr jasności (wysokość), to SDR jest drastycznie ograniczony.

To, co jednak daje możliwość wyświetlenia tak dużej liczby kolorów, to brak dostrzegalnych dla naszego wzroku stopni w przejściach tonalnych. Wszystkie sceny, w których kolory łagodnie przechodzą z jednego odcienia w drugi, są praktycznie niemożliwe do poprawnego zrealizowania korzystając z 8-bitowej reprezentacji składowych barw, której używa SDR. Dla HDR wymogiem jest korzystanie z 10-bitowej reprezentacji, co pozornie wydaje się niewielką różnicą (ot, 25% więcej „bitów”), ale w praktyce przekłada się to na przeskok z 16 milionów barw na ponad miliard! Mówimy zatem o dwóch rzędach wielkości poprawy ilości odcieni, jaki obraz zakodowany w HDR jest w stanie nam ukazać.

Starsze lub najtańsze wyświetlacze oferują czasem jeszcze gorsze przejścia, jako że korzystają z 6-bitowego panelu…

Podsumowując – HDR zapewnia nam:

- Znacznie bardziej wyróżniające się rozświetlone fragmenty sceny

- Dużo więcej detali w cieniach

- Nieporównywalnie bardziej żywe kolory

- Przejścia tonalne bez widocznego stopniowania

Jakie istnieją standardy HDR oraz czym się różnią?

Najbardziej podstawowym standardem, który został zatwierdzony przez organizację Ultra HD Forum, jest HDR10. Wykorzystuje on statyczne metadane (zakodowane w materiale, który odtwarzamy), które informują telewizor, jakie będą dla danego medium maksymalne wartości jasności (na podstawie najjaśniejszej sceny) oraz jak radzić sobie z kolorami, których telewizor fizycznie nie jest w stanie wyświetlić. To format, w którym obecnie dostępne są niemal wszystkie media dostarczane z szerokim zakresem dynamiki i jest on używany w sytuacji, gdy nasze urządzenie nie wspiera bardziej zaawansowanego formatu, opcjonalnie oferowanego przez dane źródło. A czym są te opcjonalne formaty HDR?

Dolby Vision i HDR10+, czyli HDR z dynamicznymi metadanymi

Poza zwyczajnym HDR10 często spotyka się również Dolby Vision oraz HDR10+. Podstawowa różnica (względem HDR10) w tym przypadku to wykorzystywanie dynamicznych metadanych, które pozwalają niezależnie dla każdej sceny (a w teorii nawet każdej klatki!) ustalić osobne dane dotyczące szczytowej jasności oraz mapowania tonów. Dzięki temu telewizor wie, jak dostosować parametry swojej jasności, aby wyświetlana treść w pełni wykorzystała jego potencjał. Ciemne sceny nie będą zbyt rozjaśnione, a w tych najbardziej jasnych nie uświadczymy „clippingu", czyli zlewania się detali.

Dzięki HDR dostrzegamy detale w cieniu oraz na fragmentach prześwietlonych w SDR.

Łatwo sobie to zobrazować, jeżeli wyobrazimy sobie, że telewizor w chwili uruchomienia filmu w HDR otrzymuje od niego instrukcję, w której zapisano, jak ustawić maksymalną i minimalną jasność dla bieli i kolorów. W przypadku HDR10 to drobna notatka z jednolitymi wartościami dla całego filmu, podczas gdy formaty z dynamicznymi metadanymi oferują obszerne tomiszcze, które dokładnie opisuje, jak w każdej kolejnej scenie filmu zmieniają się te wartości. O ile wyświetlacz jest w stanie podołać z wyświetleniem dla każdego typu sceny obrazu o parametrach przekazanych przez statyczne metadane, to nie ma większego problemu, ale niestety z tym radzą sobie tylko najlepsze i najdroższe modele. Tymczasem obecność dynamicznych metadanych pozwala na ich podstawie dostosować parametry obrazu do każdej sceny, aby nadrobić „sprzętowe braki”.

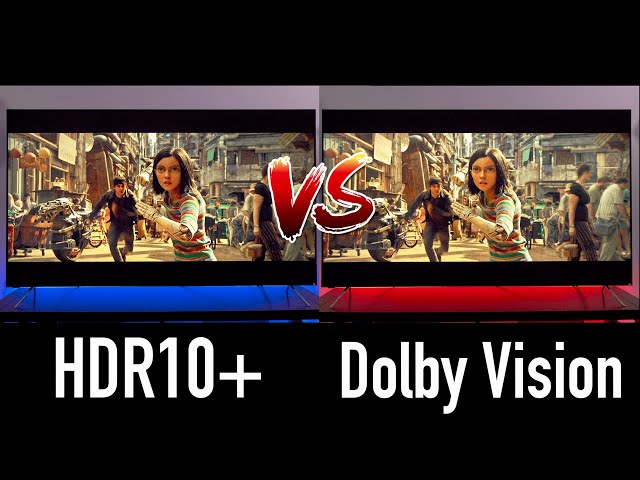

Co lepsze? HDR10+ czy Dolby Vision?

Mimo pozornie takiej samej zasady działania, oba wspomniane formaty dynamiczne nie korzystają z takich samych metadanych i niestety urządzenia, które wspierają jeden format, niekoniecznie poradzą sobie z drugim (i tym samym będą skazane na używanie podstawowego HDR10 lub SDR, jeżeli źródło nie ma tej podstawowej warstwy HDR). Zasadnicza różnica sprawdza się w tym przypadku do właśnie mapowania tonalnego, które wykonuje nasz wyświetlacz na podstawie otrzymanych metadanych. Oba formaty stosują różne algorytmy zapobiegania efektu „zbijania tonów” (clippingu), co skutkuje inną reprezentacją barw tego samego materiału źródłowego. Trudno w tym przypadku mówić, które jest lepsze, jako że oba co do zasady są błędem odwzorowania (koniecznym w celu uniknięcia clippingu), a z subiektywną opinią jest jak z końcem pleców – każdy ma swoją. Wyśmienite porównanie obu formatów, z wykorzystaniem tego samego telewizora, znajdziecie na kanale VillaMan – mimo iż pochodzi z 2020 roku, to nadal jest wysoce aktualne.

W znacznym uproszczeniu można powiedzieć, że HDR10+ oferuje wyższą jasność i więcej detali w cieniach, podczas gdy Dolby Vision stawia na nieco bardziej nasycone kolory oraz ich kontrast. Zwykle jednak nie będziemy stawać przed dylematem „z którego formatu HDR korzystać”, jak że obecnie praktycznie żadne media nie są już dostarczane w obu formatach jednocześnie. Zatem albo nasz wyświetlacz oferuje wsparcie dla danego HDR z dynamicznymi metadanymi, albo będziemy zmuszeni używać HDR10 i mieć nadzieję, że nasz sprzęt ogarnie statyczne metadane.

Dlaczego mój telewizor nie ma Dolby Vision/HDR10+?

Jeżeli zastanawiacie się, od czego zależy to, czy dany wyświetlacz wspiera jeden albo drugi format dynamicznego HDR, to witamy w klubie, jako że dla nas to również niepojęta zagadka. W teorii HDR10+ jest formatem darmowym, zatem producent wyświetlacza nie musi uiszczać żadnych opłat licencyjnych, aby zaimplementować wsparcie dla tego formatu. Dolby Vision takiej licencji już wymaga, ale w praktyce dla producenta telewizora to dodatkowe kilka dolarów kosztu produkcji telewizora, zatem zdecydowanie nie jest to kwota której dodanie do ceny wpłynęłoby na pozycjonowanie danego modelu na rynku.

HDR z dynamicznymi metadanymi najwięcej daje na słabszych wyświetlaczach.

Oczywiście w obu przypadkach dochodzi koszt rozwoju i wdrożenia danej technologii do samego produktu (tzw. R&D), ale to akurat koszt jednorazowy, zatem po rozłożeniu na wszystkie wyprodukowane egzemplarze nie powinien znacząco wpłynąć na ich cenę. Nie sądzimy zatem, aby chodziło o pieniądze, zwłaszcza że to akurat tańsze marki, takie jak TCL czy Hisense oferują wsparcie dla obu formatów, podczas gdy producenci premium, jak Sony, Samsung czy LG, uparcie trzymają się tylko jednego rozwiązania, próbując stale przekonywać konsumentów o jego wyższości nad tym drugim. Nietrudno się domyślić, które podejście jest chętniej wybierane przez klientów…

HDR Adaptacyjny - o co chodzi?

Oba omówione standardy HDR z metadanymi doczekały się jeszcze wariantu, który dodatkowo bierze pod uwagę... natężenie oświetlenia w naszym pomieszczeniu! W przypadku Dolby mowa o Dolby Vision IQ, a w drugim przypadku jest to HDR10+ Adaptive. Zasada działania jest prosta - telewizory wspierające ten wariant HDR muszą posiadać wbudowany czujnik jasności i na jego podstawie regulują maksymalną jasność, z jaką będzie operować nasz telewizor. Dzięki temu telewizor automatycznie zwiększy swoją jasność, gdy dany film oglądamy za dnia, oraz obniży ją, gdy oglądamy go w zupełnej ciemności, tak aby zapewnić zbliżone wrażenia, niezależnie od warunków otoczenia. Powiecie, że to bez sensu, bo i tak zawsze używacie maksymalnej jasności? My też :)

Format uniwersalny – HLG

Pewną ciekawostką jest HDR HLG – format opracowany przez BBC (brytyjska stacja telewizyjna) we współpracy z NHK (japoński nadawca telewizji), który w samej nazwie skrywa swoją specyfikę. Skrót HLG rozwija się jako Hybrid Log-Gamma i nawiązuje do tego, że standard ten automatycznie wykrywa, czy odbiornik „umie w HDR”, czy rozumie tylko SDR i w obu przypadkach obraz będzie wyglądać dobrze. Pozwala to oszczędzać przepustowość podczas transmisji, co, wiadomo, jest kluczowe w przypadku telewizji, ale zasadniczo format ten w kwestii jakości nie ma przewagi nad podstawowym HDR10.

Wraz z rozwojem AI w telewizorach i na komputerach pojawiła się trzecia opcja – Auto HDR

Mimo wszystkich zalet, jakie posiada obraz kodowany w HDR, ma on jedną zasadniczą wadę - koszt produkcji. Nie tylko potrzebujemy lepszego sprzętu do kręcenia filmów w HDR, ale również późniejsza jego obróbka również jest znacznie bardziej złożona i czasochłonna. Nic zatem dziwnego, że to SDR nadal jest najpopularniejszym formatem w mediach społecznościowych oraz nadal żywej klasycznej telewizji. Nie oznacza to jednak, że nic z tym zrobić nie można i trzeba się godzić na marnowanie potencjału naszego monitora lub telewizora. Wszystko dzięki rozwojowi AI, które obecnie potrafi samo rozszerzyć zakres dynamiki obrazu do możliwości naszego sprzętu!

Tak ma działać funkcja Auto HDR Remastering w telewizorach Samsung, ale na ten moment realny efekt jest daleki od powyższego.

W przypadku telewizorów efekt ten nie jest jeszcze powalający, co wynika bezpośrednio z ich mocy obliczeniowej. Część producentów, jak Samsung, mocno stawia na rozwój tego typu funkcji AI i faktycznie efekty uzyskiwane przez nich są już całkiem niezłe. Ale prawdziwe możliwości w tej kwestii pokazują dopiero komputery. Już podstawowa funkcja Auto HDR wbudowana w system Windows 11 (dostępna również dla Windows 10) daje efekt lepszy od tego, co oferują telewizory, ale prawdziwa magia zaczyna się, gdy faktycznie użyjemy AI, np. w formie NVIDIA RTX Video HDR – tutaj faktycznie można odnieść wrażenie, że obraz od początku był renderowany z szerokim zakresem dynamiki.

Obecnie najlepszy automatyczny HDR oferują karty graficzne NVIDIA GeForce RTX.

Jaki sprzęt najlepiej radzi sobie z HDR?

Wszystko, co wyżej opisaliśmy, dotyczy samych możliwości standardów HDR, zatem tego, ile w teorii można zyskać. Jednakże finalny efekt będzie zależeć od tego, na co pozwala nasz sprzęt. Aby w pełni korzystać z tego, co oferuje HDR w filmach czy grach, koniecznie będzie oczywiście posiadanie wyświetlacza, który taki sygnał potrafi dekodować. W przypadku monitorów pomocna jest certyfikacja VESA HDR, która nie tylko jasno określa, czy wyświetlacz zrozumie HDR, ale również, na jakim poziomie ten efekt będzie w stanie dostarczyć.

Z powyższej tabelki jasno wynika, że wyświetlacze z oznaczeniem HDR 400 należy omijać szerokim łukiem, jeżeli zależy nam na faktycznie doświadczeniu HDR. Owszem, będą one w stanie dekodować sygnał HDR, ale ten nie będzie się specjalnie różnić od obrazu, jaki generują w SDR. W praktyce dopiero HDR 1000 jest certyfikatem, który zagwarantuje nam efekt wow po przełączeniu z SDR na HDR w przypadku tak certyfikowanego wyświetlacza. Jeszcze lepsze w tym przypadku będą panele, które uzyskały dowolny poziom certyfikacji DisplayHDR True Black, jako że w ich przypadku mówimy o perfekcyjnym kontraście i najlepszej kontroli jasności na scenie.

Najlepszy efekt HDR obecnie oferują wyświetlacze micro LED, ale z uwagi na ich cenę trudno uznać je za konkurencję dla zajmujących drugie miejsce paneli OLED

Niestety w przypadku telewizorów raczej nie stosuje się tej certyfikacji. W tym przypadku ogólnie o tym, czy dany wyświetlacz będzie „robić robotę” w HDR decydują trzy czynniki – maksymalna luminancja, rozmiar (a zatem ilość) niezależnie sterowanych stref wygaszania oraz poziom pokrycia szerokiego gamutu kolorów (DCI-P3). W przypadku wyświetlaczy LCD najlepiej sprawdzają się te zdolne wygenerować ponad 1000 nitów jasności z pomocą podświetlenia mini LED, które podzielono na znaczną ilość stref. Jak znaczną? To już zależy od producenta, ale zwykle jeśli będzie to przynajmniej 4-8 stref na cal przekątnej, to powinniśmy być zadowoleni podczas filmowych seansów. Naturalnie panele micro LED oraz OLED wypadają tutaj zawsze idealnie, jako że w ich przypadku każdy piksel jest osobno sterowany. Tu jednak warto zwrócić uwagę na maksymalną jasność panelu, jako że w tej kwestii spora część OLEDów właśnie nieszczególnie błyszczy.

Budowa OLED jest znacznie prostsza, co nie oznacza, że są to tańsze wyświetlacze…

Warto również zauważyć, że OLED nie zawsze oznacza to samo – od 2022 roku na rynku mamy telewizory z nową generacją OLED, w której kolor uzyskuje się z pomocą technologii kropek kwantowych, dzięki czemu nie tylko są jaśniejsze, ale również w znacznie większym stopniu pokrywają wolumen kolorów HDR. Obecnie takie matryce QD-OLED można odnaleźć nie tylko w najlepszych telewizorach topowych producentów, ale również w monitorach dla graczy.

Skąd brać treści HDR?

Zakładając, że nie chcemy korzystać z funkcji Auto HDR i zależy nam na prawdziwym sygnale o szerokim zakresie dynamiki, to powinniśmy skierować się ku cyfrowej dystrybucji mediów. Obecnie praktycznie każda rozpoznawalna platforma VoD oferuje część treści w HDR, choć często są one dostępne tylko po wybraniu (i opłaceniu…) droższego pakietu subskrypcji. Nic w tym dziwnego, jako że sygnał HDR zużywa więcej przepustowości łącza i bardziej obciąża serwery usługodawcy. Możemy również zaopatrzyć się w odtwarzacz BluRay i filmy odtwarzać właśnie z takiego nośnika, co ogólnie oferuje najwyższą jakość obrazu z uwagi na znacznie mniejszą kompresję niż przy streamingu.

Aplikacje VoD w telewizorze zwykle informują, czy dana produkcja jest dostępna w HDR – zwykle też rozpoznając, jakie formaty HDR rozumie nasz sprzęt.

Pamiętajmy jednak, że posiadanie odtwarzacza BluRay, który wspiera HDR, nie oznacza, że nasz wyświetlacz nie musi już tego samego robić. W szczególności dotyczy to telewizorów bez obsługi Dolby Vision (np. Samsung), które filmy z nośników optycznych (zwykle kodowanych właśnie z pomocą HDR Dolby) będą wyświetlać jedynie w standardowym HDR10. W przypadku gier sytuacja jest w sumie całkowicie poza naszą kontrolą - część twórców dodaje natywną obsługę HDR, a część pozostawia nas na łaskę „Auto HDR”.

Często dobry monitor z HDR znacznie bardziej poprawi jakość oprawy wizualnej niż topowa karta graficzna.

HDR a gry – o czym warto wiedzieć?

W tym przypadku warto jeszcze wspomnieć o formacie HGiG, z którego często korzystają gry jako alternatywy dla HDR10+ Gaming oraz Dolby Vision for Games (zatem odmiany wspomnianych wyżej standardów HDR, zmodyfikowanych pod potrzeby graczy). Oferuje on również dynamiczne metadane, co pozwala uniknąć clippingu, który w grach jest znacznie częściej spotykany, jako że to gracz kontroluje kamerę i niekoniecznie będzie unikać takich „trudnych kadrów”.

Na ten moment (połowa 2024 roku) jedyne konsole, które są w pełni zgodne ze wszystkimi technikami HDR, to Microsoft Xbox Series-X oraz Series-S. Naturalnie PC również oferuje wsparcie dla wszystkich formatów HDR, choć w tym przypadku Windows 11 nie radzi sobie aż tak dobrze z ich obsługą, jak robią to konsole. PlayStation 5 miało dostać wsparcie dla Dolby Vision (które obsługują również telewizory Sony), ale możliwe, że dopiero odświeżona wersja PlayStation 5 PRO dozna tego zaszczytu.

Komentarze

15Ale wracając do HDR. Dopóki nie będzie ustandaryzowanego HDRu. to nigdy nie zrobi to prawdziwej rewolucji

"podczas gdy producenci premium, jak Sony, Samsung czy LG, uparcie trzymają się tylko jednego rozwiązania"

OLEDy z LG mają wsparcie Dolby Vision, HDR10, HLG. I dolby jest raczej lepszym wyborem, bo dużo więcej filmów jest w tym formacie.

Mogli by dorobić wsparcie dla HDR10+ i Adaptive jednak, no ale jak producenci telewizorów oszczędzają nawet na porcie ethernet i dają max 100mbps (i to nie w tanich modelach) to nie ma co liczyć ;)